话说,性取向这事儿,

一直都是一个很私密的话题…

人们可以有各种理由选择出柜,也可以有各种理由待在柜子里。

自己到底是直是弯,就像脚板底袜子的破洞一样,只有自己心里清楚….

但是….

终于,科学技术发展到这一步了….

斯坦福的两名研究员造出了一款‘鉴gay神器’,仅凭一张照片,AI就能识别出对方是直是弯,准确率高到惊人!

是技术无罪,还是有伦理问题?

他们两人(毫不意外地)引发了一场大论战…..

这两名研究员是电脑专家Yilun Wang,

和Michal Kosinski。

Wang曾经在谷歌工作过,在2016年他在斯坦福大学就专攻人工智能,是个技术派。

Kosinski是大数据专家和心理学家,爱好是通过人们在社交网络上的足迹来研究人类的行为。

Kosinski以前就搞出过不少有争议的大新闻,

比如通过分析人们脸书上的自我介绍,来判断他们的人格;

通过脸书上的活动,来预测人们是选择脱欧还是留欧;

最有名的是,他的大数据技术帮助川普团队找到潜在的支持者,被认为成功帮助川普当上总统….

‘脸书上留下的所有痕迹,不管是有意还是无意的,其实都是在做心理测试题。’他说。

这一次,Kosinski盯上了约会网站上的…gay们。

他和Wang想知道,在照片数量足够多的情况下,能不能通过AI,让它判断一个人的性取向。

两人在美国一家很受欢迎的约会网站上随机挑选了14,776人,其中男女弯直,数量均等。

在这1万多人中,再随机挑选他们的照片,最终得到35,326张图。

因为约会网上上每个人都清楚地写了自己的取向,只要把照片和取向在电脑上同时输入就行了。

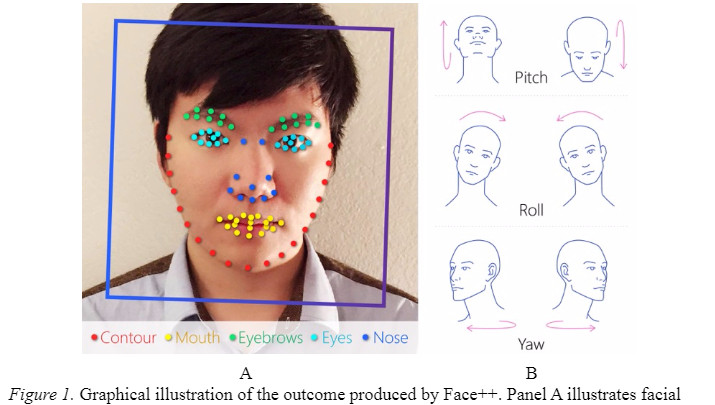

之后,他们用一种很主流的分析人脸的工具,Face++,将照片上的面部特征用数据的方式分析出来。

然后让电脑通过一种叫做‘深度神经网络’(Deep Neural Networks)的判别模型,学习这些脸部特征,最终,AI能够判断一个从来没见过的人,他的性取向是男是女….

以上这些听上去没什么,

但重点是结果…..

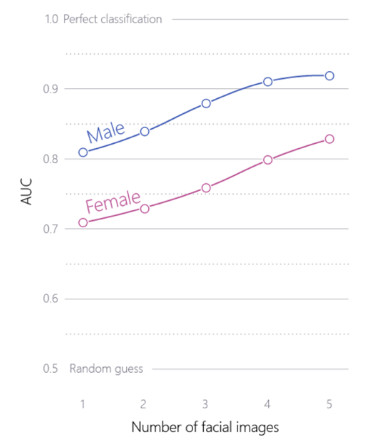

他俩发现,AI‘鉴gay’的准确率高,得,惊,人:

如果,

把一张直男照和一张gay照放到AI面前,它找出gay的准确率有81%!

如果每人不止给一张图,而是5张,那么它判断出gay的准确率会飙升到91%!!

AI在鉴定蕾丝的能力上要差些,

如果只看一张照片,那么准确率是71%,

如果每人给5张照片,准确率是83%。

(下图是随着照片数量的增加,准确率上升)

但是人呢?

人判断他人直弯的准确率如何,不是号称有‘gay达’吗?

嗯,Kosinski和Wang随机找了一帮美国工人,

也是给他们看同样的照片,但人判断的准确率,对基佬,只有61%,对蕾丝,是54%(近乎于瞎蒙了)…

Wang和Kosinski还找到很多有趣的信息:

在电脑分析的时候,他们发现异性恋与同性恋在脸部上的差别,主要集中在几个地方。

(下图红色部分)

对男性而言,鼻子,眼睛,眉毛,脸颊,头发和下巴,这些地方的不同能够让AI识别出他的性取向;

对女性,则是鼻子,嘴角,眉毛、头发和领口。

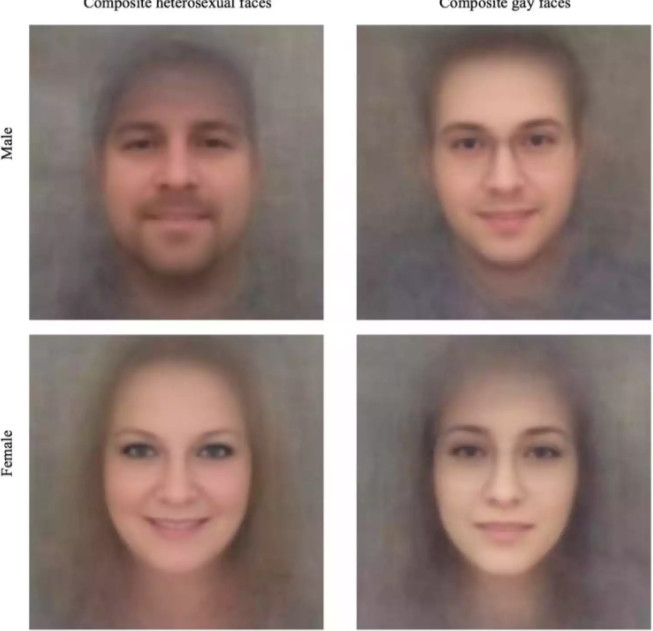

通过大数据分析,Wang和Kosinski发现,

总体而言,同性恋男人的鼻子比直男的鼻子更窄、更长,他的脸也更瘦长一点;

而和直女相比,同性恋女人的颌骨较大,额头较小。

(下图左列为直,右列为弯)

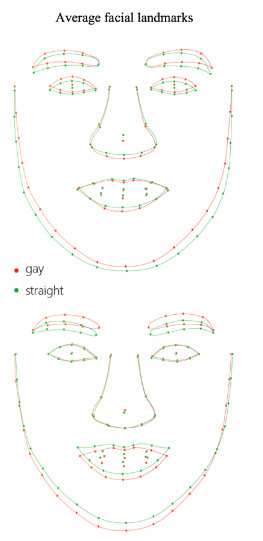

这是他们绘制出的特征图,

红笔画的是同性恋的脸型,绿笔是异性恋的脸型。

为什么双方在脸上会出现差异呢?

两人在论文中写道,他们认为这个结果证明了‘胎儿激素暴露理论’。

这几年来,有这么一种理论:

当胎儿在妈妈的子宫里时,子宫里某些激素的过高或过低,会导致孩子出生后的情绪和行为的不同。

曾经有科学家发现,

胎儿过多地暴露在紧张激素下,成年后更可能有情绪问题…

激素还能影响孩子们的性取向,和童年时不同的行为特征…

两位斯坦福研究员认为,

在子宫里时,因为过少(对男胎)和过多的雄性激素(对女胎),导致一部分人是同性恋,并且这些激素对他们脸部的形成、个人喜好,和行为都有影响。

这就是为什么,性取向和脸可以有联系。

两人的论文经过诸多大牛的同行审核,在上周在业内顶尖的《人格与社会心理学期刊》上发表….

两人本来挺开心,

但是在《经济学人》的记者9号报道了这篇论文后,

他们遭到了来自网友的猛烈抨击….

人们一开始的态度是:

完全拒绝,同性恋和异性恋不可能长相上有差异。

著名的同性恋权益团体GLAAD和HRC发公告驳斥这篇论文。

他们主要的论点是,这篇论文非常不严谨,是一项‘垃圾研究’,比如整个研究样本里都是白人,缺少有色人种,没有经过同行审核(其实审过了),没有调查双性恋,没有区分性取向和性行为,等等….

所以,他们的结果不可信。

Kosinski觉得,这完全是感情用事。

他转推了另一个教授的话:

‘因为和你的意识形态不一样,所以全盘否认一项科学结果…你最终可能伤害到你爱的人。’

他们还写了一篇长长的‘作者的话’,把同性恋团体的论点都开拆分析,力证自己没有错…

另一群网友的观点是:

好吧,就算性取向和脸部差异挂钩,

但是,

我是啥取向就是啥取向,为什么要让你知道?

你有什么权利知道?

这个AI是侵犯个人隐私。

但Kosinski说,他们做这个研究,其实就是想提醒政府,保护现在人们的隐私(论文的结尾里也这么写道)。

他说,两人使用的技术并不稀奇,都是前人用过的,找这些照片也非常容易。

他们想以此来警告政府和广大公司,是时候保护人们的隐私,不让这一切信息如此容易得到。

‘以前的研究证明,人们可以通过他人在社交网路上的足迹,判断出他们的性取向。

但是这些信息是可以被掩盖、被刻意改变的。但一个人的脸不太可能被掩盖…’

‘在约会网站、社交网络、政府官网,有几十亿人的照片。这些信息太容易被得到了。

我们的研究证明了,这些公开的数据,加上传统的工具,能够让人造出判定性取向的仪器,不经过允许就能知道对方是直是弯。

现在政府、社会,和同志团体应当更快地意识到这种危险…不公布这个研究,可能会延缓政府推出法律,保护人们的隐私..

Wang和Kosinski在论文里说,

他们知道这么做可能会提醒人们去做此类AI,起到反效果,但为了尽快让政府行动,他们还是选择公布。

不过由于这些内容标题没有提,加上写在太后面,很少有人注意到….

Kosinski不满地发推:

看来没有人问问 ‘好吧,假设他们是对的,那么我们接下来该怎么保护自己呢?’

Kosinski是非常郁闷,

他俩的‘初衷’也可能确实没有错,

但是…..

他们可能忽视了一个大问题:

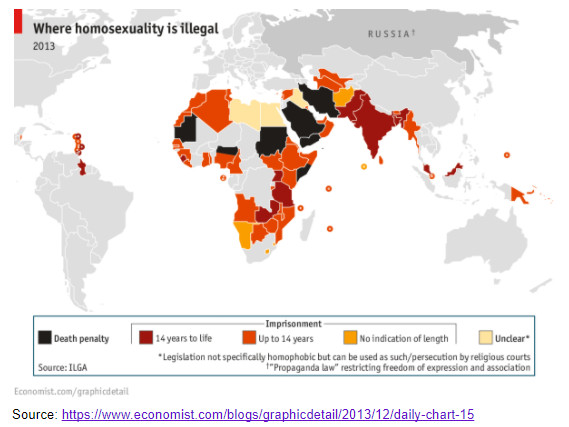

在全世界,有很多国家把同性恋还当做一项重罪,

这项技术可能被政府使用,通过看人们的脸,就能揪出谁是同性恋,然后把他们铲除干净。

(下图红色部分,当同性恋要坐牢,黑色部分,当同性恋会被判死刑)

‘想一想,这项有缺陷的研究可能被用于支持邪恶的政府迫害他们认为是同性恋的人。’HRC的官员Ashland Johnson说道,‘斯坦福大学以后应该远离这种垃圾研究,有损它的名誉。因为这个研究,数百万人的生命都或多或少变得不安全。’

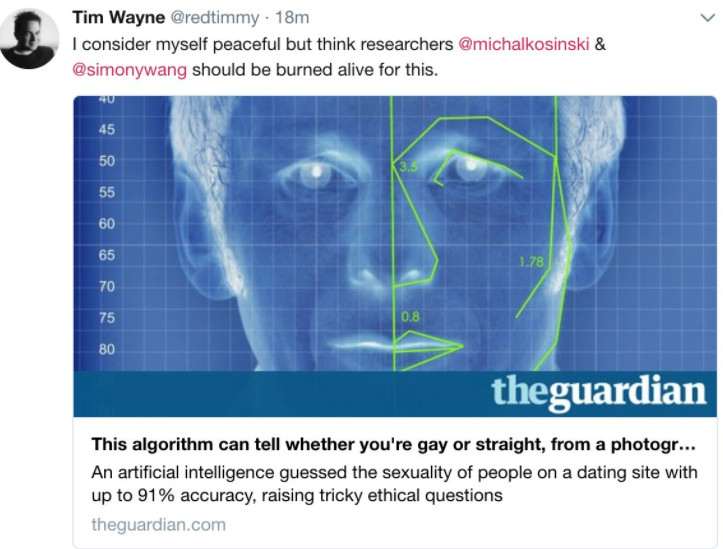

网友愤怒地写道:

我努力让我自己平静下来,但是想到这两位研究员,Michal Kosinski和Simony Wang,我真想让他俩被活活烧死。

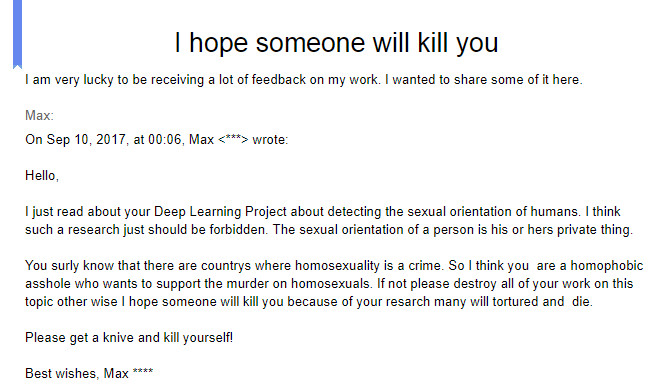

还有人寄恐吓信:

…你们绝对知道在世界上的某些国家,当同性恋是重罪。所以我觉得你们肯定是恐同分子,想借他人之手谋杀同性恋!

如果你俩不是的话,拜托马上把这个项目的研究资料全部销毁,不然的话我真心祝愿有人能把你们杀掉。

求你们了,拿把刀自杀了吧!

对这一切,Kosinski告诉卫报记者,

他没有向大众放出过能够使用的AI程序,他也不会让其他人使用。

他自己认为,这项研究其实是对LGBT有好处的,因为这证明了同性恋纯碎和生物原因有关,而不是个人选择。

‘对那些宗教团体和煽动者,这是一个强有力的论据。’他在采访中说,‘当他们问你‘你为什么就是死活不改变?你为什么不服从我们?’你就能说,我就是不能,因为我生来如此。’

但也许是吵得太凶,

Kosinski自己对这项研究也有点后悔了,

他多次告诉记者,‘我真希望有人重复我的实验,证明我是错的….如果我是错的,我可能是最开心的那个…’

目前,因为抗议太多,

《人格与社会心理学期刊》的主编们表示会对这篇论文重新审核。

ref:

https://theoutline.com/post/2228/that-study-on-artificially-intelligent-gaydar-is-now-under-ethical-review-michal-kosinski

https://twitter.com/michalkosinski

https://amp.theguardian.com/world/2017/sep/08/ai-gay-gaydar-algorithm-facial-recognition-criticism-stanford

https://www.glaad.org/blog/glaad-and-hrc-call-stanford-university-responsible-media-debunk-dangerous-flawed-report

https://docs.google.com/document/d/1UuEcSNFMduIaf0cOWdWbOV3NORLoKWdz3big4xuk7Z4/edit#

https://www.economist.com/news/science-and-technology/21728614-machines-read-faces-are-coming-advances-ai-are-used-spot-signs?fsrc=scn/tw/te/bl/ed/advancesinaiareusedtospotsignsofsexuality

https://www.theguardian.com/technology/2017/sep/07/new-artificial-intelligence-can-tell-whether-youre-gay-or-straight-from-a-photograph