在又一次观看一名男子惨烈的死状后,Chloe的情绪再次崩溃了。

过去三个半星期里,她一直在接受入职培训。

而培训的内容,就是学会识别网络上各种违规内容。

这些内容或许是因为过于色情暴力,或许是因为宣传极端言论而违反了社区规则,都需要及时地被识别和删除。

目前的人工智能还无法精准地将这部分内容筛选出来。

所以,国外的各大社交网络公司都需要雇佣大量审查人员来进行人工筛查。

Chloe就是这个日益扩大的人工审查员队伍中的一员。

然而,这个为了维护网络和谐的工作,本身却一点也不和谐:

每天都在面对各种刺激画面的审查员们,

有的如同Chloe一样,时不时就情绪奔溃大哭;

有的为了发泄压抑,在公司里和同事们发生性关系,一起喝酒浇愁…

为了审查而长期看一些极端言论,有的久而久之慢慢被自己审查的内容洗脑,开始渐渐相信曾经认为荒谬的错误言论;

甚至有的人只有带着枪来上班,才能给自己找到一点安全感….

在这个充满着仇恨、暴力、色情、歧视的世界,

为了创造一个和谐的网络环境,他们正在承受着常人无法想象的痛苦….

【性、毒品、黑色笑话:无处发泄的审查员们通用的解压方式】

Chloe是一名来自美国亚利桑那的年轻女孩,目前在位于凤凰城的公司Cognizant工作。

Cognizant是一家为其他网络公司提供审查服务的机构,最主要的客户就是世界最大的社交网络公司Facebook。

公司里的所有员工都需要认真研究Facebook的内容规则,锻炼个人迅速判断内容是否违规的能力。

在Cognizant,稳定的审核岗员工平均年薪是28800美元。

相较于Facebook员工每年二十多万美元以上的年薪,这份服务Facebook的工作收入并不高。

但相较于Chloe老家的工资却丰厚不少,每小时可以多赚4美元。

所以,即便是这份工作饱含太多暗黑的成分,Chloe培训的三周半里也一直在咬牙坚持。

这天,她又打开了一个“暴力”视频。

视频中有人正在用匕首刺伤一名男子,男子一边尖叫一边大喊饶命。

短短几分钟的视频里,男子被捅了十多刀,直到死亡。

这是Chloe筛选出来的极端视频之一,也是她培训过程中的一个作业。

在看完后,她需要在讲台上和全部同事解释这个视频是否违规,如果违规,是违反了哪一条规定,确认违规以后该如何处理。

她努力保持镇定,在播放完视频后站上台和大家讲解。

但她内心的恐慌使她的声音难以抑制地颤抖,好不容易讲完回到座位上后,她产生了一种非常强烈的想要嚎啕大哭的冲动。

等到又一名同事上台开始讲解时,Chloe忍不住冲出了房间,开始放声哭泣,大口喘息。

没人上前来安慰她,大家都已经习惯了。

在公司里,有1000多人和Chloe一样在承受着类似的心理压力。

这就是他们的工作,要么接受,要么辞职不干。

哭了两分钟后,Chloe缓过神来,擦干眼泪回到房间,继续听同事们分享案例。

即便是培训结束或者下班以后,Chloe心中的压抑感依然挥之不去。

但是,因为和公司签署了保密协议,Chloe不能和外人倾诉自己内心的痛苦:

他们不能和公司以外的人透露自己的工作到底在干什么,

不能向外人透露那些违规内容的细节和上传违规内容的用户信息,甚至不能让人知道Facebook是公司的客户。

所以,内心有再多的焦虑、恐惧,Chloe都只能自我消化,避免违反保密协议而丢掉工作。

渐渐的,Chloe也意识到公司里的其他人其实也在承受着和自己一样的痛楚。

他们表面上看起来那么淡定,其实私底下在用各种“极端”的方式发泄自己的痛苦。

比如,公司里的人会从和同事的性关系中寻找快感和放松。

大家都承受着同样痛苦的精神压力,都在长时间地面对各种黑暗负面信息,都无法向家人朋友倾诉烦恼,

所以每个人环顾四周,往往会发现,只有同公司的同事是自己能放心倾诉的对象。

同病相怜的一群人在公司里互相安慰的时候,渐渐会通过性行为来纾解内心郁结。

虽然这种解压方式在明面上肯定是被禁止的,但在私底下却关不住。

卫生间隔间、楼梯间、停车场,甚至是公司里原本为哺乳期的母亲保留的育婴室,都成为了性关系发生的场所。

有人将这种行为称为“疗伤”,

工作让他们受伤了,希望性爱能促进伤口的愈合。

急需多巴胺刺激的员工们,就这样在用性来缓解内心的焦虑。

不过,解压性性行为并不是最极端的员工放松方式。

在Chloe的公司里,很多老员工会在休息期间一起抽烟甚至是抽大麻来缓解自己的压力(医用大麻在亚利桑那州是合法的)。

他们一边靠烟草来麻痹自己的神经,一边通过分享黑色笑话来缓解紧张的气氛。

自杀、他杀、性、歧视性言论,都可以成为他们调侃的素材。

只有这样,他们才能在短短10分钟不到的休息间隙里,最大程度地恢复兴奋状态,

之后继续集中注意力,投入到工作中去。

因为如果不及时调整自己的状态,等待自己的可能并不是公司配备的心理咨询师的安慰,

而是业务主管的责问和不久后的解雇通知…

【休息是为了更好地工作:正式员工们也在苦苦煎熬】

就算熬过了培训阶段,这份工作也不会如同辅导员所说的那样简单、让人渐渐适应。

实际上,通过培训的Chloe在之后的工作中依然常常崩溃。

作为审查公司的管理人员,Cognizant的项目经理并不是不知道员工们的痛苦。

尤其是在过去两年一些媒体曝光了审查员的精神问题后,迫于舆论压力,像Cognizant这样的公司都给员工们配备了一系列解压服务。

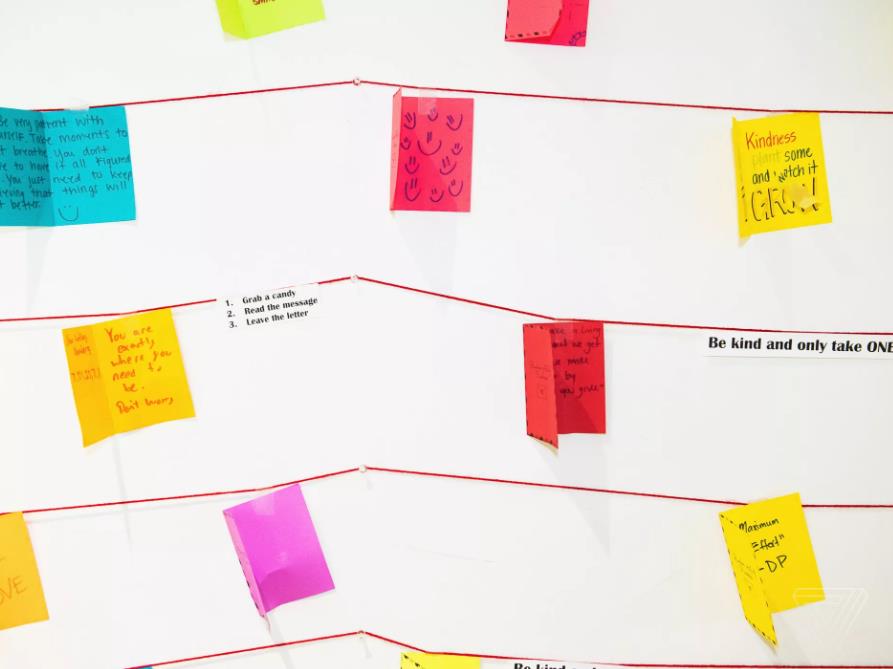

比如说公司的环境看起来非常明亮、友善,到处都是提醒人世界真美好的小贴纸。

除此之外,公司还为员工们配备了比传统客服中心更多的心理咨询师。

但这些措施在实际操作层面,作用并不是很大。

Chloe的亲身经历中,公司的心理咨询师给员工的帮助非常有限。

有一次,她在休息室里崩溃大哭时,人们朝她投来责备的眼光,她只能躲到厕所里继续哭泣。

这时候,有一位心理辅导员找到了她,给了她一个轻轻的拥抱,并向她解释:

“惊恐到崩溃是正常的,当培训结束后你会对自己的情绪更有控制力。

现在如果受不了,你可以暂停视频,或者把视频的声音关掉。

多来几个深呼吸,别太在意你看到的东西。

不用担心,你一定能胜任这份工作的。”

Chloe听完后并没有觉得有多大安慰,在主管看来,她的痛苦都是应当的,关键是调整自己继续工作。

更何况,即便是这样不走心的安慰,也是很难得的。

大多数时候,心理辅导员每天可能只有一小时的时间接受员工们的咨询。

为了和辅导员倾诉一下内心的痛苦,员工们可能要排队等很久,等到后可能也就只能聊几分钟,对缓解压力真的没太多帮助。

时间久了,Chloe也渐渐理解和接受了老员工们那种极端的解压方式。

更严重的问题是,公司对员工的“体谅“始终建立在“工作效率至上”的原则上。

每天,公司会有一个30分钟的午休时间,两次15分钟的中途休息时间,和一次9分钟的“健康时间”。

在这些休息时间里,公司的卫生间常常会爆满。

由于卫生间配备数量跟不上,很多人在规定的休息时间里可能根本来不及去上厕所。

于是只能在那个9分钟的“健康时间”里去卫生间。

但是,这种利用“原本应该用来放松”的健康时间去上厕所的行为,却是公司管理人员不允许的。

不准上厕所,那所谓的“健康时间”到底应该用来干嘛才是“对健康有利”的呢?

按照公司的原计划,在这个时间段员工们可以做做瑜伽,一起冥想放松,或者做些简单的运动。

公司对员工的严格控制还体现在一些“禁令”上。

公司的储物间非常小,为了保护客户公司的用户隐私,审查员们不准带任何有记录性质的物件进入公司。

普通的纸张、笔记本不行,甚至是口香糖的包装纸都不能随意带入公司。

所有进入公司的物品,都必须放在一个透明的袋子里供管理员检查,以防员工“叛变”将公司的信息带出去。

审查员们一方面在审查网络内容,一方面也在被自己的公司审查…

【高压的工作让人心怀怨念,为了防止老员工报复带枪上班】

相对于员工的心理健康,公司更在意他们的工作效率和对公司形象的维护。

一个熟练的审查员平均要在30秒内判断一个帖子违规与否,每天平均要完成400个帖子的审查。

如果效率不高,每天只能审完200个帖子左右,就会被管理人员约谈。

即便在规定时间里完成了规定数量的工作,员工也要为自己的准确率担忧。

公司每周会从个人的审查任务中抽取50-60个帖子来检验他们的准确性。

而检查帖子的人,本身也是公司的审查人员,只是更“高级”一点而已,每小时能比普通员工多赚一美元。

加上各个网络公司的审查规则平均每个月会有一次新的更新,总有一些内容模棱两可,似是而非,让人难以判断。

这时候,员工往往只能结合上下文自己大胆判断。

这种“大胆判断”的结果就是拉低个人检测准确率。

一旦准确率下跌到95%以下,员工可能就会被开除。

除了工作的强度和难度,审查员们的工作还包含了一个安全威胁因素:“路人”的恐吓!

很多老员工都遇到过类似的事情:

在公司的停车场,一些不满网络审查制度的陌生人,会上前来挑衅和威胁公司的员工。

这些人可能是因为发布的不当言论被审查员封号了,所以前来报复,

有的可能是自己发的内容或者关注的内容被“无故”删除了,心怀不满,

在他们眼里,错的不是自己,而是负责审查内容的审查员们。

所以尽管他们不知道删除自己帖子的究竟是谁,还是会前来挑衅审查公司的员工,发泄自己的不满。

Cognizant公司的员工Randy在自己工作的第一年,遇到过五六次这样的威胁。

到后面,被吓到了的Randy甚至只能带着枪来上班:

他担心愤怒的路人们哪天真的对自己下狠手,而自己却毫无还手之力。

所以即便公司是不允许员工持枪上班的,他还是申请了一把手枪来给自己壮胆。

从公司的角度这种管理方法似乎很合理:

为了维护客户公司的利益,为了不过于敏感地删除掉一些原本合规的内容,也为了不让不合规的内容肆意传播,对审查员的严格要求就是维护网络不要被暴力凶杀和极端思想充斥的方法。

然而,从员工的角度,这份工作实在是太磨人了,所以员工的流动率非常高。

很多人离职时和公司不欢而散,甚至可以说对公司充满怨念。

因此,公司的现有员工还会受到另一层威胁:

已经被开除的曾经的员工,可能会回到公司来报仇。

所以当时Randy的那把枪,不完全是用来防不满审查制度的冲动路人,也可以用来应付有可能发生的“公司惨案”:

在公司里里外外有那么多对公司心怀不满的人,而他们工作接触到的内容让他们深感世界上危险无处不在,

看似明亮宽敞安全的办公场所,也难保会有袭击事件的发生。

带枪不仅是为了防外人,也是为了防发狂崩溃的曾经的“自己人”。

【辞职后阴影也不会散去,长期凝视深渊的人最终可能会被深渊吞噬】

不管是培训期还是正式工作阶段,审查员的工作看起来都很艰辛。

但是也不是所有人都会崩溃到放弃,还是有一部分人最终适应了这份工作,并最终为自己的工作感到自豪。

一部分接受杂志The Verge采访的审查员表示,这份工作的确会让人的精神深受创伤,

但是熬过了创伤,个人也会因此变得更加坚强。

在他们眼里,这种坚强,叫做创伤后的成长。

能够从创伤中成长起来,他们感到非常自豪,因为如果不是他们的辛苦工作,Facebook这样的网络世界将会变得非常丑陋。

况且,这份工作相对于他们很多人之前做的服务员、收银员工作,

至少不会被客户无缘无故地谩骂指责,看起来还算高大上的工作环境也让他们觉得更加体面。

这些坚强的员工只是审查员群体中第一部分,还有很大一部分人是没有熬过创伤的人。

创伤没有让他们变得更强大,而是让他们在离职后的日子里依然痛苦。

比如,前文提到的Randy和Chloe在追踪报道中,都没有熬过一年就辞职了。

甚至在辞职之后,Randy依然没有从工作带来的恐慌中恢复过来。

如果有机会去做心理评估的话,他们可能都患上了创伤后应激障碍。

Randy曾经很喜欢做饭,但现在因为看了太多的暴力视频,对“刀具”一类的东西感到恐惧,因而不再敢进入厨房。

因为看了太多袭击、屠杀的视频,现在早上起来后,他常常会拿着枪在自己家周围巡视一圈,确定没有入侵者后才敢回到房间里。

但创伤后应激障碍还不是这份工作最难对付的后遗症,

很多接受采访的审查员表示,审查工作常常会在三观层面改变审查员。

“我们正在做一些让灵魂变得黑暗的事情。”

这个问题并不难理解:

当你凝视深渊的时候,深渊也在凝视你。如果意志不够坚定,个体也可能会被深渊吞噬。

在审查员身上这个规律也有体现:

很多人开始相信一些曾经的自己觉得荒谬的事情,

比如地球是平的,大屠杀不曾发生过,911根本不是恐怖袭击…

他们开始怀疑人生,也怀疑这个世界。

【即便充满暗黑和刺激,审查员依然是如今世界必要的存在】

人类语言、情感的复杂性,注定了社交网络内容的繁杂、难以捉摸。

比如,一个写满“我恨所有人(men)”相似言论的ID,在审查员看来是违反规则的,

但一个失恋的女孩写的“我失恋了,我恨所有的男人(men)”的帖子,在审查员看来就没有太大危害性。

这两种内容对于人工智能来说可能差距并不大,只能靠人来仔细分辨。

所以,只要有人在创造暴力、色情、散播仇恨的内容,就有人不得不面对这些极端的内容。

网络审查员的确是那一堵将普通网民与暗黑信息相隔绝的保护墙。

至于这面墙是否会受到暗黑信息的伤害,大多数人都是不关心的。

凤凰城的员工们,或许并不是压力最大的审查员。

在世界上其他国家,还有几万审查员在为Facebook,为Youtube,为Twitter这样的社交平台提供审查服务。

他们拿着可能更低的工资,在更为逼仄的环境里努力地工作着。

即便这样,他们可能还是会对自己这份工作心怀感激和珍惜,因为他们知道在这个世界上还有更多比审查员更辛苦的工作。

或许,在人工智能发展到能够替代网络审查员之前,这种伤害就很难彻底地停止。

只能依靠更多的人力投入,降低他们的工作强度,提供更多的心理健康支持来缓解审查员们受到的创伤。

而这部分投入,在没有媒体曝光、舆论压力的情况下,

无论是被服务的例如Facebook,还是提供服务的Cognizant,都不会主动为员工提供。

所以,或许作为普通的观众,我们个人无法冲到一线去替代审查员的工作,也无法简单地否定审查公司存在的必要性,

但我们可以用自己的关注,让网络社交公司们更加重视这部分审查员的心理健康。

关注这些代替普通大众凝视深渊的人,也是个人维护和谐的网络环境的一种力所能及的手段…

Ref:

https://www.theguardian.com/news/2017/may/21/revealed-facebook-internal-rulebook-sex-terrorism-violence

https://www.theverge.com/2019/2/25/18229714/cognizant-facebook-content-moderator-interviews-trauma-working-conditions-arizona